格灵深瞳CEO赵勇深度总结:揭开人脸识别和国内智能安防的真实现状

五、智能安防接下来该怎么走?

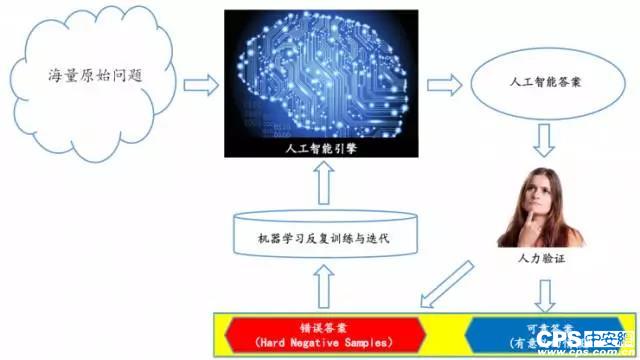

1.人工智能+人类智能

在此我推荐一种方法,就是海量的原始问题进来以后,先由人工智能引擎回答,然后产生人工智能的答案,但这些答案里的多数答案是错的,这种情况下可以把这些答案交给专业人员去验证。人类验证的好处是当一个答案可以通过人类的验证,结果对于客户来说这个情报至少是值得关注的。

另外,那些没有通过真人验证的错误答案,也都是很有意义的答案数据。通常它们都是比较接近正确答案的错误答案,这类数据对提高机器学习模型的改善和迭代也是非常有意义的。

如果我们在产品里设计出这么一个流程,使得人工智能识别引擎在精度不断提高同时,客户也能够得到比较有意义的情报。

把大量的人工智能和少量人类智能结合起来,会产生一个较好的互补效应。

2.人工智能+大数据

另外一种手段就是人工智能+大数据。

为什么需要大数据?刚才我也提到,当我们有了底层结构化数据再到完成客户整个业务体系,本来就需要很多大数据挖掘应用,但更重要的一件事情是随着结构化数据规模上涨,大规模智能系统产生的误报会显著上涨,以至于正确的情报会淹没在海量误报中。这件事情必然会发生,尤其对于人脸识别而言。

我现在觉得全国各地的城市已经开始拥有一定规模的人脸识别,但我相信很快所有的客户都会踢到铁板,误报会大规模地上升。现在已经看到很多客户发现了这件事,这种情况下有没有解?当然有,我认为解企业要通过大规模的、多模态数据整合来提升人工智能的精度。

这是什么意思呢?如果我们单看一个单点人工智能的识别结果,它的错误率并没有足够好,就算可以做到千万只分之一的错误率,但只要问题数量过多,误导还是很多。

但是当你使用了更多规模的数据,比如一个人在运动时。他在轨迹路线上是否能够被反复识别,或者说轨迹所体现的行为,同时能够印证这个人的可疑性,或者说关于一个目标的多模态数据:他的车辆、消费记录、手机信号、wifi探针、社交关系,把这些不同模式的数据能够整合起来。

我再给大家举个例子,比如说小明和小王是同班同学、好朋友。我在北京某个地方看到一个人长得像小明,那么结果可能不一定是小明,可能只是一个跟小明长得很像的人。但是我如果在同一个地方又看到了这个小王(小明的朋友),那么确认这个人是小明的概率就加大许多。

这只是一个例子,其实有大量的规律、模态、组合可以把这个任务做得更好。所以我觉得是未来人工智能产品必须注意的一个方向,也是我个人觉得成功的人工智能公司必须具备的条件:要有很强的大数据分析能力。

六、前沿生物视觉技术在安防领域的应用

接下来我给大家分享一些在安防领域里面落地的前沿且有趣的技术。

大自然是一个非常丰富的知识库,我们可以从里面学到很多知识。计算机视觉是关于“视觉”的,所以我们来关注一下人的眼睛以及动物的眼睛。

从眼睛模型中我们可以看到它有个“快门”,也就是所谓的瞳孔,“镜头”是我们眼睛的晶状体,“传感器”则是眼球里面的视网膜。

其实人的眼球跟数码相机本质上没有特别大的差别,但相机实际上已发明 100 多年,今天我们的相机无论是很贵的数码单反还是 iPhone 上的相机,它其实和 1839 年发明的第一台相机在成像原理上没有本质的不同。不过是通过小孔成像原理,把真实的物体通过倒影呈现在背景的传感器上。这么多年唯一发生变化的就是镜头变得越来越好了,传感器变得越来越好了。但是在这个过程中呢,成像的基本原理还只是一个投影问题。

1.怎样解决三维变二维时丢失的距离信息

我们的世界是一个三维世界,每一个物体都是三维的,它投影的结果是在一个平面上,无论它是相机底片平面,还是眼球的球面。最终还是变成了一个两维的数据,在这个过程中三维压缩到两维,丢失了什么吗?丢失的是深度信息,也就是纵深方向距离的信息。

我再给大家举个例子,在这张照片里几辆汽车放在一起。与此同时有一辆玩具车被一个人拿在手里,如果不是因为照片里的手指,很多人都误以为这就是停车场上的一辆真车。你可以看到图像里物体真实的大小不代表它的实际大小。最近这辆红色的跑车其实是很小的,可是远处一辆在树背后的车看上去很小,但实际上真实车的尺寸比较大。一个物体在图像中的尺寸跟他的真实尺度不一定有什么关系,当你失去了尺度,就没办法衡量尺寸、距离、速度、加速度。这种情况下,我们去分析物体的行为就有了很大的问题。

我们再来看一个自然界的现象,这里显示了一些动物照片,这些动物都有共同特点:都有两个眼睛。而且两个眼睛都有比较大的视场角重叠,大家有没有意识到所有捕食动物的眼睛都朝前长的,所以他们两个眼睛的视野重叠比较大,重叠最大的好处是可通过两个眼睛对图像的视差的分析,能够计算出这个目标的深度,有了深度以后就可以去追捕他。

而所有被捕食的动物,比如羊、骆驼、马的眼睛都长到了侧面,然后形成了一个 360 度的全景。它最大的优势就是可以更有效地去防范周围的捕食者,它可一边吃草,一边看脑袋后面有没有捕食者在靠近。

其实在计算机视觉领域,就有很多技术可以利用多视场能够计算出来物体的深度。

格灵深瞳根据这种原理推出一款名为皓目行为分析仪的产品,皓目行为分析仪用一种结构光的方式生成 Depth Video,然后基于数据去分析人的行为。

我给大家看一个简单的展示,在这个展示里面有很多人在相机跟前走动,他们之间产生了很多遮挡。

但是即使在遮挡发生的情况下,我们仍然可以很好地把每一个人跟踪下来,给每个人腰上套了一个圈,这个圈有不同的颜色,画面的左下角是一个俯视的雷达图,雷达图上方代表相机,下方代表它视野,然后每一个点它的颜色和视频里这个人腰圈的颜色是对应的,所以你可以看到每一个人的轨迹。通过这种方式就可在一个比较复杂的场所分析人们轨迹的行为。

比如说有没有人在追逐、停留很久、徘徊,我们也可以分析人是不是摔倒了,有没有剧烈动作等等。

如果要分析剧烈动作,需要对他身体的姿态动作做一个更深入地分析。在这里面我们开发了一套算法,能够从图像里把他的关节、胳膊、腿的位置计算出来。大家可能会意识到类似的功能在微软或者 Primesense 等公司的人机交互产品里面实现过。

格灵深瞳则是开发了一套专门针对于安防监控的识别算法,不同的地方是它可以在监控视角,快速实现初始化比较好的工作。

2.昆虫复眼原理给光场相机的启发

此时有人会有质疑,不是所有的动物都有两只眼睛,昆虫就不是,昆虫的眼睛叫复眼,有几千个镜头。

这是怎么回事呢?这组照片上显示了很多昆虫的眼睛,你一眼看上去的确是看到了复眼,但即使是复眼,它们也有个共同点,第一是它们有一对复眼,第二个是他们的眼睛针对他们的头部来说很大。

为什么要长这么大的眼睛呢?作为相机来说,它的感光量是很重要的指标。如果感光量不够多、不够大,很难形成清晰的照片,因为形成照片需要光子跟传感器发生能量的交换。能量的交换要能够被测量下来才能形成对颜色、亮度的识别,这就是为什么好的相机比如说单反相机它有很大的光圈。

但是昆虫身子的尺寸非常小,在这种情况下为了保障进光量,就要尽量大地增加光圈的尺寸,所以这就是昆虫的眼睛为什么这么大。

第二件事情就是为什么昆虫的每个眼睛变成了复眼?如果你要给昆虫用传统的光学模式设计眼睛,你会面临什么挑战?假设你是蜜蜂,在你的生活中要不断去寻找鲜花采蜜,有的时候你要看到几十里外的目标,然后飞过去。可是当你在采蜜的时候站在花瓣上要能够看到花粉在哪个花蕊上,然后去收集它。

也就是说,你要既可以看到很远的物体,又能够看到很近的物体。在这种情况下,它对变焦镜头的变焦动态范围要求非常高。普通镜头很难做到在这样一个范围内去变焦,尤其镜头体积还有大量的限制,这就是为何昆虫在自然界中自然进化出了这种形态的眼睛。

今天我们把这种成像模式称作 Plenoptics,简单来说就是一个镜头或者传感器阵列。这种阵列的特点是能够在一个平面上去接受更大的光场,然后把光分布,包括它的方向等信息捕捉下来。广场是四维的、光学的 Representation,获得光场之后可通过算法把不同的成像方式的结果全部计算出来。今天这种技术已经可用来做一些有趣的产品。

比如美国加州有一个公司,他们有一个基于光场原理的相机,你在拍照的时候可以直接拍。但是你回到家以后,可对这个照片做重新聚焦的修改,也就是先拍照片,然后再去定它的焦距。

我们今天会发现,如果想要实现一个非常大的、动态的变焦范围,最有效的方式就是来做光场相机。而昆虫的复眼就是非常精确的光场相机,这是一个非常奇妙的现象。

接下来,我们来看一个例子,在这个例子是讨论人脸识别的。

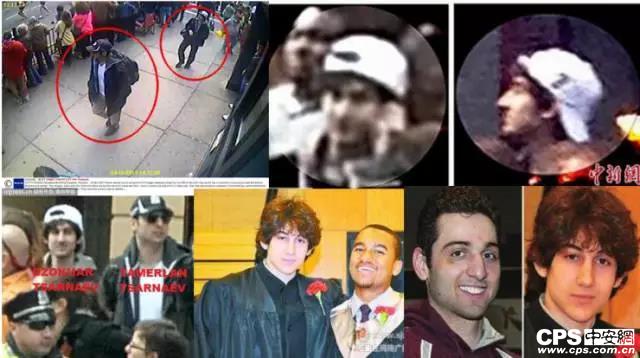

在这个画面的左上方是 2013 年 4 月 15 号在波士顿发生的马拉松暴恐案,事件爆发以后警方得到了这张照片,很显然这张照片是从一个监控的摄像头上拍摄的。在这张照片里,两个嫌疑人离镜头都不算太远,前面这个人可能离镜头有两、三米,后面那个人大概五、六米。但我们发现在这么近距离的情况下两人的面部是看不清楚的。

后来美国警方使用众包的方法来寻找线索,把这张照片在电视台上滚动播出,大概在 36 个小时以内有很多马拉松观众用自己的相机拍了很多照片,这些照片里面正巧有几张拍到了嫌疑犯。在画面右上方和左下方就是游客后来提供给警方的照片。其中左下方这张照片帮了很大的忙,因为这两张照片是两个嫌疑人,肩并肩站在一起并且正面对着镜头。

根据这张照片两人成功被举报,右下方 3 张照片是这两个人的生活照,根据这个线索,这两个人最终被抓住了。

在这个过程中,我们发现这么一个现象。今天大多数人脸识别还是卡口式的人脸识别,比如我把这个东西装在地铁的出口,商场入口等等,因为人们必须从这些地方经过,你就不得不被相机看到。但事实上,假设你是一个犯罪分子,如果你看到了一个相机离你这么近,那就可能不从这儿过了,或者你头会故意低下来,让相机看不到脸。

其实人脸识别的应用必须发生在人完全不配合的场景中,他完全注意不到附近有一个摄像头。当他不知道附近有摄像头时,那他被抓拍的几率就很高。所以格灵深瞳开发的人眼相机产品主要是为了实现这个目标,我们现在识别的距离可以达到 50 。我们自己做过一个实验,当你站在一个地方,然后你要想确保你周围 50 米内都没有一个摄像头的话,这是比较难的一件事,因为空间比较大。

3.人眼原理给相机的启发

这是办公室停车场的一个案例,当格灵深瞳的人眼相机对接到了我们的动态人脸识别引擎上来,面部就会被抓取到。

最远的可能 50 米,一部分为二三十米,然后他们的面部就和员工照片库进行实时的比对。

人眼相机的原理其实和哺乳动物的眼球工作原理非常相似,人用裸眼看这个世界时是可以看得比较远,我自己在开车时发现一个非常特殊的现象,我大概可以发现我至少可以看到前方大概 30 米到 50 米的车牌号码。可是当我安装了一个行车记录仪时,我发现我把视频调出来看,当前面的车离我的距离超过八米到十米时,我就看不清这个画面里的车牌号码。

那这意味着什么?人眼的分辨率真比高清摄像头高很多吗?其实并不是的,只是我们的人眼的视网膜里有一个特殊的区域,叫黄斑。

黄斑非常小,尺寸有多大呢?如果你把眼球的中心跟黄斑连接起来,那么这个椎体的角度只有 2.5 度左右,但在这么小的一个地方,集中了人眼 75% 的有效像素,剩下 25% 的像素分散在整个 160 度的视场角上。一个人的单眼视场角是 160 度,通过一个视场角很广但分辨率不高的一个注意力检测系统和一个视场角很小但分辨率很高的黄斑系统共同工作,实现对世界的观察。

我们读书不断地扫描每一行文字,我们开车时眼球的注意力也在不同的目标上切换,这就是眼睛工作的原理。人眼还有一个重要特点,它的光学系统和它的识别系统紧密地结合在一起,并且相互反馈。在一个瞬间我们的余光注意到一个物体,如果我们认为它重要的话,大脑就会指挥眼球转动,把我们的黄斑会迅速聚焦在物体上面。

这种反馈使得眼睛非常的灵敏,人眼相机就是实现了光学系统和人的检测,以及人脸识别系统接对接和反馈。从大自然的角度来讲,我们发明了一个工作方式与人类眼睛一致的设备。

这就我今天的分享,谢谢大家。

声明:

凡文章来源标注为"CPS中安网"的文章版权均为本站所有,如需转载请务必注明出处为"CPS中安网",违反者本网将追究相关法律责任。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

相关阅读

征稿:

为了更好的发挥CPS中安网资讯平台价值,促进诸位自身发展以及业务拓展,更好地为企业及个人提供服务,中安网诚征各类稿件,欢迎有实力安防企业、机构、研究员、行业分析师。投稿邮箱: tougao@cps.com.cn(查看征稿详细)