格灵深瞳CEO赵勇深度总结:揭开人脸识别和国内智能安防的真实现状

这里面有一个重要的机遇,道路上客户的摄像头分 3 种:电警、卡口、监控摄像头。

所谓电警和卡口,通常是在十字路口或者高速公路的进出口上搭了一个龙门架,或者有一个装了摄像头的架子。

这些摄像头使用了很高的分辨率,角度也非常合适,它可以在正面增加识别的成功率。但是像电井和卡口这样的摄像头,它只占整个道路周边摄像头数量的很小一部分。以北京为例,电警和卡口摄像头的数量占道路全部摄像头数量的千分之一左右。

还有更多摄像头是普通的视频监控摄像头,这些摄像头数量很多,分辨率也不是特别高,因为它们要录制视频。一般在安装的时候都是为了监控整个大场景,所以视场角较大,视场角变大的坏处就是针对每一个目标它所能够分配的像素数量会降低。

这个时候,监控视频里看到很多目标并不是很清晰:没有补光、照明不够、图像模糊现象很严重。如何在这种低质量的数据、不理想的环境下仍然把视频识别做好?这在某些方面决了定我们能否把道路监控大视频、大数据这个事情做好,这一领域的产品其实还有很多的改进空间。

当基础数据被识别出来后,基于这些数据就可做各种各样的大数据分析。以格灵深瞳为例,我们开发了一个车辆大数据的平台叫威目大数据平台。

给大家做一个非常简单地演示,我们在客户的现场选择了一些摄像头,之后选择一个区域。然后就可以搜索一些不同品牌的车,比如奥迪、宝马等等。在搜索“奥迪”之后,你可以选择其中任何一辆车然后看看它出现在了什么地方、什么时间,随后可在地图里做进一步搜索。

大家可以想象,当我在一个空间里能够得到很多搜索结果时,这些不同结果的时空关系会为我们提供一个轨迹信息。这些轨迹信息会给我们更强有力的分析手段去分析一些人的行为,这里面有各种各样的战法,所谓战法就是警方客户在破案或在分析一些数据时采用的一些不同的手段和流程。

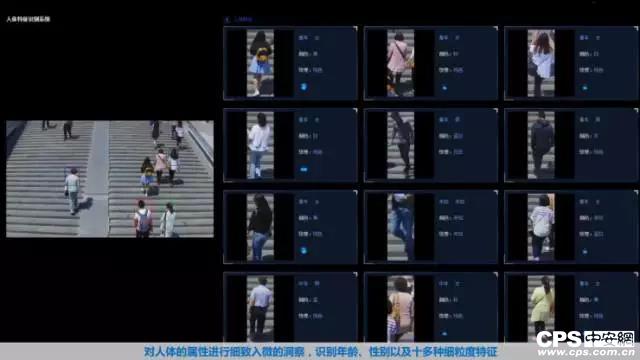

2.人物属性识别

刚才是车,我们现在来看一下关于人的识别。

这套视觉系统能够对画面里的行人和他的属性结构化,也就是对人物的基本属性做一些判断:如性别、大致年龄、行李属性、衣服颜色、衣服类型。如果可以看到正面的话,就可以看清他的有没有戴口罩和戴眼镜,有没有留胡子等信息。

这些信息其实跟人脸识别不太一样,它是一种短效、对分辨率要求不高时得到信息的一种途径。

当我们很多人对安防监控不熟悉的话,就会觉得街头上的安防监控摄像头一定会把人脸识别出来。但事实上,今天绝大多数普通的安防监控摄像头根本不可以满足人脸识别分辨率的条件。

首先它们的视场角往往设置的比较广,第二是他们离人的距离比较远。

在这种情况下,虽然可以看清这个人的外形,但要想看清他的面部,尤其想在面部区域得到一个比较高的分辨率,至少是 80×80,或是 100×100,分辨率高是提升人脸识别效果非常重要的因素。

当今街道上这些普通监控摄像视频里面,虽然看不清脸,无法做人脸识别,但是我们如果能够从他身上得到他的其他属性,也是很重要的元素。

举一个例子,比如有一个小孩走失了,目击证人提供的线索是看到一个穿着红颜色衣服的中年妇女抱着这个孩子。那么我们就可以根据上述提到的属性去搜索:中年、女性、红色衣服、抱着孩子,把这 4 个特征输到搜索系统当中,即可迅速地找到目标。

3.人脸识别

我们再来看下人脸识别,要想得到一个比较靠谱的识别结果,画面的距离如下图展示的这样。

在这里,我们联通了一个普通的高清摄像头。在这个摄像头中我们特地选择了一个焦距比较长,为 15 毫米以上的镜头放在一个办公室的走廊顶端。我们发现,环境里差不多有效识别人脸的宽度最多为三米。当然也可以使用一些更长焦的镜头把识别宽度推到更远的地方,或用短镜头把识别宽度放在离相机比较近的地方。但是无论你怎么试,它真正有效的识别宽度也就三米左右。

通常我们得到一张低分辨率的人脸,比如说 30×30 以下,那么它在一个很大的数据库里去做搜索的效果,肯定非常不理想。通常要求一个人脸最好是达到 100×100 个像素以上时,它的搜索结果就会非常精确,甚至可以在一个很大,如几百万、几千万人的数据库里做有意义的搜索。

人脸识别技术在过去几年进展非常大。和 3 年前相比,我们去看一个标准测试集时,错误率可能已经小了上千倍。我们训练人脸模型时,尤其要注意光照、角度、表情问题,能不能够去抗干扰。

视频中大家也可以看到,人员自己去做一个挑战,每一位员工在工作期间无论在办公室里还是在外面的院子,都能被我们的人脸识别系统拍到很多照片。

我故意让他们走到摄像头跟前来做鬼脸,看看谁可以把脸做如此夸张以至于人脸识别系统会产生错误的识别。大家可以看到有一些人在做鬼脸,有些人在弄乱自己的发型。

三、AI 应该用在前端还是后台?

未来智能化一定会在安防监控行业非常普遍且深入的发生,但它在实现时可放在不同的设备里,有时候可以把智能放在前端,如摄像头里,甚至录像机里。也可以把一些智能放在后台的数据中心、服务器上去运算,到底什么样的分配是一种比较合理的分配。关于这个问题,我想给大家分析一下。

1.把智能放在前端的好处

我觉得智能放在前端最大的好处是针对一个视频流时,它所有的运算资源都专注于前端。放在前端有一个好处就是大量数据,用不着通过非常拥挤的网络传到数据中心去。

我们要意识到安防监控网络上的数据都是视频文件,它的码流、数据量比其他任何形式的文件大很多。

你想象一下,如果你有一个千兆的以太网,那么这个千兆的以太网能够同时传多少视频?

一般来说,一个高清的视频码流都会到 2 到 4 MB,也就是说在一个千兆以太网上,可能最多放个一两百个视频就会把这个网络全部占满,所以把智能放在前端的好处可以节省一些带宽。

2.智能放在后台的好处

把智能放在后台的好处有点像云计算,云计算的一大优点是分享,我在后台可以用非常强大的硬件、非常复杂的软件把识别性能做得非常好,因为人们对识别的精度要求永远是无止境的。但这样会导致对识别算法、硬件要求比较高,如果放在服务器里可以达到这个条件,同时分享给不同的前端。

其次,如果把这些设备放到后台,那么它的算法升级、运维都会比较可靠,不像前端摄像头如果发生了软、硬件故障。尤其是硬件的故障,维护会非常麻烦。

3.哪些功能应该放在前端摄像头中

我个人是这么看这个问题的,视频里面的检测、跟踪、去重:检测就是对目标的检测,跟踪就是跟踪这个目标在摄像头里画面中的移动,去重就是我把它送去识别时,从多次的检测中选一个比较好的视角去检测,把很多重复的检测去掉。

这 3 项内容特别适合也应该放在摄像头里面去做,为什么呢?因为这些内容跟摄像头画面里到底有没有目标是无关的。你如果不检测也不知道有没有目标。

这部分运算是随着视频流的启动,一直需要开动,它不存在分享这件事。这样识别应该放在这个摄像头的前端来做。通过检测、跟踪、去重后,把识别的对象作为照片流通过网络传到后台,这时候它已经是一个截屏图像或者是截图的一小部分,数据量很小。而且这个数据量和目标的多少,以及场景里面活动的激烈程度相关:当人比较多时数据就多一些。当夜深人静人比较少的时候,它就没有数据。

这样一来,把识别放在后台服务器来做,就可保障识别精度做得更高。比对就不用说了,因为你每识别出一个物体,就要跟一些客户的敏感目标库做比对,看他是不是一个值得关注的对象。

近期,我在市场上发现了这么一个迹象,早期很多客户安装了智能化产品,它的路数不是很多。所以很多时候就是把传统的 IP Camera 和后台的服务器直接连接起来,这样早期的方式是可行的,但是他会给客户的带宽带来很大的负担。

4.哪些功能不该放在前端摄像头摄像

当智能化产品进行推广时,我相信这种方式很难快速进行。所以当下急需解决的事就是前端智能化。我发现有一些厂商试图把识别和比对放在摄像头里去做,我认为这是有问题的,为什么呢?你在摄像头里做识别,识别产生人脸特征。由于每个公司各自的算法不同,就要求客户后台的比对系统只能对接这种特征。这样一来的话就给客户带来很大麻烦,假如我今年采购这个厂商的设备,那我的后台也需要依据这些设备来建设。

到了明年,我想采购不同厂商设备时,就会发现不兼容性。我认为图片是最兼容的、供通行的数据,所以得从客户的角度看待问题,识别算法和比对不要放在摄像头前端,回头会给客户带来很多不灵活的负担。

比对我觉得就更不应该放在前端,因为比对需要把客户的核心资源对比库放在摄像头上,在很多公安应用里面这些都是核心机密。你可以想象,如果有黑客攻击了摄像头就会从里面获取跟黑名单相关的核心信息。我认为核心信息应该永远待在数据中心,待在客户最核心的保密网络里,而非前端。这就是我对智能前端和后端分工的看法。

四、人脸识别的真实现状

接下来我想给大家讲讲人脸识别的现状和进展。

这里面有一种分裂,怎样一种分裂呢?

一些人工智能公司宣传,他们一般都会把人脸识别的性能吹得非常悬,说错误率已经达到亿分之一的程度等等。虽然这是事实,的确有时候我们发现有一些识别错误率已经低于亿分之一,但这是有前提的,譬如说静态人脸识别:如摆拍等。

还有一种场景是门禁的应用,人们为了过一个通道,然后就盯着摄像头,这时候成像条件都很好。但是对安防而言,更多时候被观测的对象没有意识到自己被观测,它的角度也不是很理想,离相机也比较远,光照也比较复杂。而且整个目标在运动中碰到照片时,它的人脸识别结果也完全不一样了。

很多公司认为人脸识别已经做得很好,但另一方面,如果大家去调查一下如果使用了人脸识别,尤其是使用动态人脸识别的客户,大多数客户都认为误报率太高,而且高到基本上这个系统就没有办法使用。

1.是人脸技术不好,还是大家在撒谎?

今天趁这个机会,我也想非常坦诚地跟大家分享一下这里面的原因。到底是人脸识别技术还不够好,还是大家在撒谎。

做人脸识别它的优点是速度快,一张显卡每秒钟可产生几百张脸的特征,完成数千万张脸的比对,这个目前已经可以做到了。它的成本也低,使得这项技能可以快速复制、大规模地部署,性能很稳定且可持续提升。人工智能的缺点是应对复杂问题应对能力差,除此之外是对环境变化的适应能力弱。

人类的智能跟人工智能相比,几乎是完全相反的。

人类智能的优点正好是人工智能的缺点,人类对复杂问题的应对能力和对环境变化的适应能力很强,但缺点就是速度慢、成本高,比较难快速复制、不大可能大规模地部署、性能也不稳定(容易受到精神状态的影响)。

2. 1 比 1 的人脸验证

我们来看一下人工智能的不同应用,先介绍下 1:1 的人脸验证。

在金融支付领域里面,有些公司开发的软件帮助客户去验证用户的身份。这类应用本质上是在回答一个问题。客户的摄像头拍一张照片,然后将照片传到后台,后台知道验证的对象是谁,并且有验证对象的身份证照片。那么它要回答的问题是“这两个人是同一个人吗?”,答案是“是”或者“否”。所以总共回答这么一个问题。

3. 1 比 N 的人脸识别(静态人脸比对)

我们再来看一下 1:N 的人脸的识别,也叫静态人脸对比。

假如客户选择一张照片,然后他拥有 N 个人的对比库。举个例子,比如在某个省的公安厅,这个省有 5000 万个有身份证的公民。这时候警方看到一个嫌疑人想调查这个人的身份,这个人是谁?

在做这件事情的过程中,事实上人脸识别就要回答很多问题。这个人是张三吗?这个人是李四吗?是王五吗?然后它要回答 N 个问题,可能还有一个最困难的问题也就是第 N+1 个问题:这个人可能谁都不是。这就叫静态人脸比对。很显然,与人脸验证相比,静态人脸比对就是更为复杂的问题。因为它总共要回答的问题总数是 N+1 个,当这个 N 比较大的时候,问题回答的难度和出错误几率就大大提升。

但静态人脸比对使用的频率比较低,只有当客户要做一次搜索时它才会使用。它使用的场景允许用户参与交互和确认。简单说就像一个搜索引擎,我在搜索结果里挑一个我认为对的,或者是我把搜索结果呈现的前几名看上去都很像,分别调查后能够快速帮客户缩小调查范围。

这种产品在过去一、两年内的推广也比较快,而且可用性相对较高。

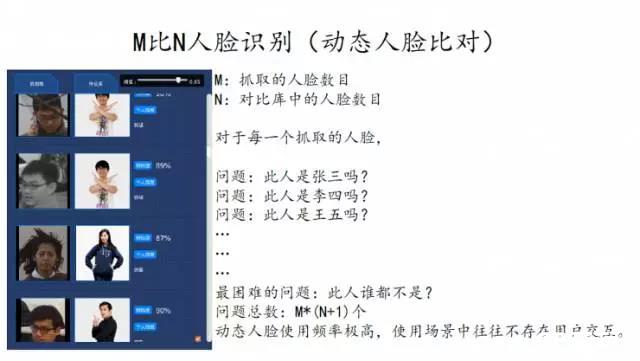

3. M 比 N 人脸识别(动态人脸比对)

我们再往下看来看一下 M 比 N 的人脸识别,通常这个叫动态认识。

何为动态人脸识别?就是客户安装的摄像头每看到一个人后,就在一个库里去比对这个人是谁,“M”代表的就是摄像头,或者网络里所有摄像头抓到的人脸数目。“N” 就是对比库中的目标数目,抓到的每一张脸都得“问”一遍:这是张三吗?是李四吗,那真的是王五吗?然后对于这个人你要问 N+1 个问题。对于看到所有 M 个人,问题的总数也就是 M×N+1 个。而且动态人脸使用频率非常高,因为它是一个全自动体系。

以北京地铁站为例,我听说北京 1000 多个地铁站里面平均每站都有上百个摄像头,如果这里面 100 个摄像头每个地铁站流通 8 到 10 万人是很常见的,可能在一些比较繁忙的地铁站有上百万人。

对于看到的每一个人都要回答 N+1 个问题,如果这个 N 是一个很大的库,比如是一个拥有十几万人的全国逃犯数据库,这就是一个天文数字。而且在这个使用场景中,它不存在用户交互,客户期待你最后产生报警,而且这个警报是值得信赖的。

我们先来看一下这个问题:

一台动态人脸抓拍机每天产生以下问题:首先假设每个相机每天看见 1 万张脸,在很多公共场所这并不是一个很夸张的假设。

我们假设对比库里有 1 万个目标,这可能对公安来说也不是一个大的目标库。如果基于该假设的话,这个相机每天要回答的问题就是一亿零一万个。如果人工智能每回答 100 万个人脸比对问题就犯一个错误,那么每一天在每一台相机上就会犯 100 个错误,也就是产生 100 个误报或者漏报。

我刚才假设每回答 100 万个问题才会犯一个错误,其实也是非常夸张的假设,因为在动态人脸识别里,很多时候人的面孔角度是不理想的,分辨率也不一定很理想,光线可能也不是很好,还可能有运动模糊。

这种情况下,如果哪个公司真的可以达到百万分之一的错误率,我相信已经非常优秀。我们想象一下,如果一个大客户装了 1000 台人脸识别相机,坦率来讲 1000 台量也不是很大,跟今天城市里已经存在的摄像头数量相比并不多。

这时候系统每天要回答 1000 亿个问题,如果人工智能回答 100 万个问题就会犯一个错误,那么客户每天就会收到 100 万个错误,也就是 100 万个误报或者漏报。我们想象一下当一个客户每天会收到 100 万个报警时,他会怎么办?那它肯定会崩溃的,因为这个系统根本不能用。而 1000 台 1 万个库的目标,每个摄像头每天看 1 万个面孔,这些假设也根本不是一个很苛刻的假设。

4.人脸识别解决公共安全问题仍然微不足道

我们能够意识到人脸识别尽管在过去几年有着巨大进展,可以在金融领域做身份验证,但它对解决公共安全问题来说是仍然微不足道的。

这个事实说明人脸识别技术不够好吗?我觉得也不尽然。人脸识别技术今天已确定超越人类。科学实验数据称,正常人最多能够记住 500 张脸,有一些销售等职业以及特异功能拥有者记住 5000 张脸也已经是极限了。

动态人脸识别的问题假如想象有一天在北京有 100 万个动态人脸识别的摄像机,而北京有 3000 万人口,在这种背景下,它每天产生的问题高达数以万万计。在这种情况下,发生错误的机率即使再低,但乘以这么大的基数也会产生海量的误报。所以这个问题的规模非常残酷。

在这种情况下我们该怎么做呢?

声明:

凡文章来源标注为"CPS中安网"的文章版权均为本站所有,如需转载请务必注明出处为"CPS中安网",违反者本网将追究相关法律责任。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

相关阅读

征稿:

为了更好的发挥CPS中安网资讯平台价值,促进诸位自身发展以及业务拓展,更好地为企业及个人提供服务,中安网诚征各类稿件,欢迎有实力安防企业、机构、研究员、行业分析师。投稿邮箱: tougao@cps.com.cn(查看征稿详细)