基于深度学习的商品检索技术

概括的讲, 为达到“所见即所得”的目标, 商品检索技术的框架中需要包含以下三个部分:

(1) 商品主体检测: 用于自动定位用户感兴趣的商品,去除背景、多主体等因素的影响,也有利于抽取的语义特征的对齐。

(2) 商品品类识别:通过识别商品的主体的品类, 使得在检索时可以在商品子数据子库进行搜索,提升检索的效果与效率。

(3) 商品特征表示: 通过学习获得商品主体的判别性特征, 使得同款商品距离更近且非同款商品相距更远; 对光照、姿态、遮挡等变化有一定的鲁棒性。

服饰检索技术回顾

基于拍照的商品检索问题本质是一个跨域(cross-domain)图像检索问题:需要根据用户输入的移动拍照图像,从电商库中获取同款或是非常相似的商品图片列表。这些特点决定了商品检索是一项综合性的图像处理技术——它涉及图像识别、检测、特征学习等各方面的内容。

其中, 服装垂类检索是商品检索中一个重要的问题。因为服装包含非常多的细品类, 而且存在非常多的视觉变化, 如光照、形变、视角、尺度、背景影响等等。解决服装检索的技术能够很好的被推广到其他垂类上。当前,很多学者和研究机构都尝试基于深度学习进行服装检索技术的探究与创新。 下文将回顾三篇基于深度学习来解决跨域服装检索问题的文章。

Where-to-Buy-It (WTBI)

这篇文章发表于ICCV2015,作者是来自北卡罗来纳大学教堂山分校的M. Hadi Kiapour。作者把street-to-shop的服装检索场景, 形式化为cross-domain的商品相似度学习问题,并设计了一种用于特定类别的相似度计算的网络参数学习方式。整个学习流程如图4所示。

图4 基于特定类别的度量学习网络

首先, 利用裙子、外套、上衣、裤子、裙子等五个主要的商品类别的同款标注图像, 基于cross entropy loss训练一个通用商品的同款判别模型;然后,对于特定细分类的商品检索模型学习问题,采用其对应的同款训练数据进行网络参数微调,将通用同款模型迁移成特定类别的同款模型。在进行方法验证时,文中还收集了40万的电商数据,以及近4万组的street-to-shop的同款商品数据。实验表明,通过这种“由粗到细”方式学习到的相似度量网络,比基于ImageNet训练的深度特征有更好的检索性能。但此文只基于离线CNN特征学习相似度, 并没有进行端到端的检索模型的探索。

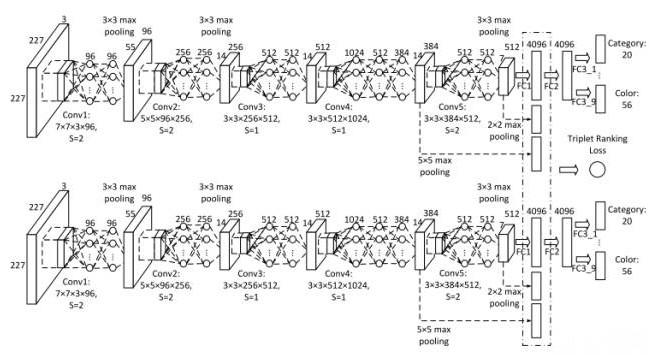

Dual Attribute-aware Ranking Network (DARN)

这篇文章发表于ICCV2015,作者是来自新加坡国立大学的Junshi Huang。此文与WTBI方法相比的不同在于:在处理街拍场景(street scenario)与电商场景(shopping scenario)服装图像之间的检索问题时,提出了一种端到端的双路神经网络模型(DARN)来学习深度特征。如图5所示:其中一路网络学习街拍场景下的服装特征;另一路网络学习电商场景下的服装特征。

图5:DARN方法的网络结构

为了提升图像检索特征的判别能力,作者还采用了多种标注数据来监督网络的学习过程:多标签的属性标注与服装同款ID标注。为此,在设计网络损失时,同时采用了基于多标签属性数据的cross-entropy loss以及服装同款ID数据的triplet loss。总的来看,网络的输出特征同时隐含了局部语义属性的判别能力以及全局表观的区分性, 在检索效果的提升上具有很好的互补性。

DeepFashion

这篇文章发表于CVPR2016,作者是来自香港中文大学的Ziwei Liu。为了使服饰识别相关的研究更加贴近实际应用场景, 作者收集了一个规模更大且语义标注更全面的服装数据集DeepFashion;它在图像数目、类别与属性数目、同款对、位置标定与数据开放等方面都占据优势。其与WTBI和DARN中的数据库对比如表格1所示。

表格1:DeepFashion与WTBI、DARN中图像数据库对比

此文还提出了一种FashionNet, 融合了大类、属性、服装ID以及关键点四种监督信息来进行服装特征学习。它的创新之处是,设计了分别对全局表观以及局部部件进行特征学习的网络;其中的局部网络结构利用了服装局部关键点对卷积特征响应图进行对齐,避免了关键点所在部件的变化带来的影响。整个网络结构如图6所示。

图6:FashionNet网络

声明:

凡文章来源标注为"CPS中安网"的文章版权均为本站所有,如需转载请务必注明出处为"CPS中安网",违反者本网将追究相关法律责任。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

相关阅读

征稿:

为了更好的发挥CPS中安网资讯平台价值,促进诸位自身发展以及业务拓展,更好地为企业及个人提供服务,中安网诚征各类稿件,欢迎有实力安防企业、机构、研究员、行业分析师。投稿邮箱: tougao@cps.com.cn(查看征稿详细)