浅谈智能视觉技术应用与发展

【CPS中安网 cps.com.cn】 通俗地说,智能视觉技术,就是通过计算机自动对摄像头采集的视频信息进行分析处理,从视频序列中捕捉存在的感兴趣区域及目标,并进一步获取目标的出现时间、运动轨迹、颜色等诸多信息,通过对各个目标的上述信息的分析。

智能视觉技术核心是运动目标检测、分类、跟踪与识别技术等。运动目标检测是将视频图像序列中的感兴趣目标(如车辆或人)检测出来,以备后续步骤的使用;目标检测的目的就是准确地从通过运动检测得到的运动区域中提取出与目标相对应的团点。

研究人员已经开发了多种运动目标检测的方法,包括帧间差分法,光流法和背景减除算法。根据实际应用需求的不同,不同的检测算法都是在可靠性、实时性和准确性之间折衷得到的。目标分类的目的是从检测到的运动区域中将对应于人的运动区域提取出来.不同的运动区域可能对应于不同的运动目标,比如交通道路上监控摄像机所捕捉的序列图像中可能包含行人、车辆及其它诸如飞鸟、流云、摇动的树枝等运动物体,为了便于进一步对行人进行跟踪和行为分析,运动目标的正确分类是完全必要的.注意,这个步骤在一些情况下可能是不必要的(比如已经知道场景中仅仅存在人的运动时)。运动目标跟踪是在需要监控的环境里,如何能够判断出进入特定区域的目标,并且能够跟踪目标的轨迹。

具体可分为两种情况:一是静态背景下的目标跟踪;二是动态背景下的目标跟踪。静态背景下的目标跟踪方法具体可分为单目标跟踪与多目标跟踪。单目标的静态背景下的目标跟踪指的是摄像头是固定在某一方位,其所观察的视野也是静止的。多目标跟踪是指在静态环境下的多目标跟踪,需要确定每个目标的特征,位置,运动方向,速度等信息。动态背景下的目标跟踪指的是摄像头在云台控制下旋转,会使得他所采集的图像时可在变化,所以,对于整个目标跟踪过程来说,背景是变化,目标也是在整个过程中运动的,所以跟踪起来较有难度。人的行为理解与描述是越来越被广泛关注的研究热点,它是指对人的运动模式进行分析和识别,并用自然语言等加以描述.行为理解可以简单地认为是时变数据的分类问题,即将测试序列与预先标定的代表典型行为的参考序列进行匹配。

当前的智能视觉技术主要集中在基于RGB光学图像的处理上,根据各种颜色空间、目标的纹理结构分析或者灰度特征、运动特征等来检测与跟踪目标,但由于RGB图像无法获取物体在三维空间中的距离信息,相关的算法受到周围环境、光照变化、背景等因素的影响,在目标检测与跟踪上鲁棒性较差,难以实现复杂场景下的任意目标检测和在线跟踪,应用受到很大的限制。

因为彩色摄像头获取的图像只保留了空间的二维信息,所以这些方法都是二维空间上进行处理,只能获得目标的二维运动信息。真实世界中的目标是在三维空间运动的,如果只获取二维运动信息将难以达到实际应用的鲁棒性要求。因此,越来越多的研究者开始利用深度图像来进行目标的检测、跟踪与识别。目前通过图像感应器获取三维信息主要有两种方式。其中一种原理与人眼视觉系统类似,采用两个彩色摄像头同时拍摄同一场景,通过两个摄像头的视差推导出场景中像素离摄像机的远近,即深度(Depth)。这种方式通常称为双目立体视觉(BinocularStereoVision)。利用双目图像推导深度信息需要先计算两幅图像像素之间的对应关系,即左边图像的像素与右边图像的哪个像素是描述的空间中的同一个点。根据投影关系,距离较远的点投射到两个图像平面的坐标偏差较小。利用这一原理可以通过坐标偏差推导出深度。

然而求左右图像像素的对应关系是一个不适定性问题(Ill-PosedProblem),因为本质上彩色摄像机捕获的表面的外观,并不包含深度信息,求对应关系只能根据外观的相似度来推导,而不是同一位置的外观也可能是相似的。因此虽然多年来学者们在这个方向上尝试了各种可能的手段,仍不能取得满意的效果。另外,计算像素对应关系以及根据对应关系并利用像素间的相关性进行优化得到深度都需要耗费大量的计算资源。到目前为止,该问题仍是一个开放性问题,没有能够产品化而得到普遍的应用。

另一种利用图像感应器获取三维信息的原理与雷达类似:采用主动的方式由一个激光发射器向场景中发射激光(一般是肉眼不可见的红外激光),然后用一个接受感应器接受反射回来。发射的激光可以是一些特定的规则模式,远近不同的对象反射回来后模式会不同(如大小),这样通过分析接收到的发射红外图像就可以得到深度信息。这种方式称之为结构光(StructuredLight)深度获取方法;发射的激光也可以是一些相位固定,远近不同的对象发射会得到不同的相位,这样根据接收到的激光的相位可以分析出激光飞行的时间,从而得到深度。这种方式称之为飞行时间(Time-of-Flight,ToF)深度获取方式。

不管是结构光还是ToF方式的摄像头,早期由于其制造工艺复杂,造价很贵,而且感应速度很慢远达不到实时,只能应用在一些专业领域。随着制造技术及电子技术的发展,最近两年来,这类利用光源获取深度信息的技术取得了突破性的进展。一些价格低廉并且速度很快的三维成像设备开始面世。不少公司都发布了可以实时采集深度信息的摄像头(例如MicrosoftKinect、

PrimeSense、华硕Xtion)等。这些摄像头可以以大于30帧每秒的速度采集分辨率超过640x480的深度图像。所谓深度图像指以像素矩阵的形式组织的场景中的深度信息,与普通图像不同的是,图像中的每一个像素的值不是颜色或者灰度值,而是该像素描述的点离摄像机的距离。Kinect是微软在2010年发布的专为XBOX360游戏机开发的体感设备,它使用结构光产生深度图像。Kinect的全身体感技术引发了基于深度信息的研究热潮如图1所示。

图1kinect体感技术演示

深度图像的处理和识别虽然不是一个全新的研究方向,但是以前由于受限于深度摄像头,其研究都局限在一些专业的领域,很多地方还是空白。随着廉价实时的深度摄像头的出现,对人机交互和计算机视觉提出了很多新的问题。从近两年计算机视觉和模式识别的顶级国际会议IEEEConferenceonComputerVisionandPatternRecognition(CVPR)上发表的论文来看深度图像处理相关的论文越来越多并且影响力也越来越大。

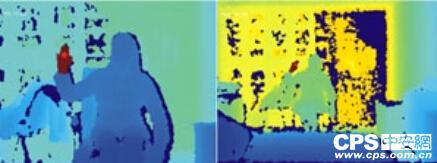

其次,由于廉价、实时的深度图像摄像头的出现,在视频监控领域也有了不俗的应用。韩国一名程序员利用Kinect开发出了一款监视边境线的系统,如图2所示。这个系统早在去年8月就开始开发,直到最近才向外界公开,并被韩国军方使用。这个系统利用Kinect摄像头的红外线功能检测穿过韩朝两国边境线的物体,能够识别动物和人。如果系统检测到穿过边境线的是人,就会立即拉响最近的警报。

图2Kinect摄像头的红外线检测功能演示

微软表示Kinect最具潜力的一个新用途就是用来确保家庭安全,它的运动跟踪系统完全可以胜任这种类似安防摄像机的工作。虽然传统的安防摄像机也可以很出色的完成安防工作,但Kinect的感应功能引入以后就可以更精准的跟踪入侵者的活动,以便让记录下了更有利用价值的视频资料。欧洲的一家高端视频监控公司也利用KINECT进行安全监控,他们开发的产品使用户可以通过手势来改变监控录像的布局,可进行录像、变焦、快退、孤立片段的操作以及内容显示如地图和网页等。

国内不少院校也对基于深度信息的智能视频技术展开了深入研究,武汉大学计算机学院国家多媒体软件工程技术研究中心采用微软公司的Kinect传感器来获取深度图像,并重点研究基于深度图像实时徒手交互中的人手检测、跟踪与手势识别技术,实现复杂背景下自然的手势交互。人手检测指交互系统初始化时判定场景中出现人手或者出现有交互意愿的人手;人手跟踪指根据初始的人手位置判断后续帧图像中人手的位置,手势识别以人手部的动作直接控制计算机的输入。

针对KINECT深度图在距离变大情况下人手轮廓模糊,无法根据手部轮廓特点来确认候选手区域,挥手检测失败的问题,根据人手形状在距离变化的情况下,长宽比例满足长条形的约束条件,引入人手形状似长条型先验知识,提出基于形状先验和运动先验的区域增长人手定位模型,形状先验按手型形状比例约束为限制,不受用户与摄像头距离远近变化的影响。克服了手部轮廓模糊无法获取候选人手及质心的困难。结合挥手运动先验,最终定位人手启动人机交互。将挥手检测的适用距离由以前的0.7米到1.8米增加到

3.2米,同时检测率达到95%,提升了挥手检测的效率,如图3所示。针对人手跟踪过程中,人手与躯干融合导致跟踪失败的问题,提出了基于邻域深度距离度量的人手跟踪模型,通过预判人手与躯干融合情况,来决定是否启动人手运动检测,恢复人手跟踪,解决了人手与躯干融合时,人手跟踪错误问题,预判融合正确率92.9%,跟踪恢复正确率92.3%如图4所示。以上研究结果在国内外发表多篇SCI、EI检索的科技文献及专利。其成果具有现实的应用价值。

图3基于深度图像的挥手检测

图4基于深度图像的人手跟踪

综上所述,智能视觉技术是安防领域中一个重要的研究分支,它在智能监控、虚拟现实、用户接口等方面的应用前景引起了广大科研人员的浓厚兴趣。更多的研究者们正逐步将其成果推向更加智能的应用场合。

(作者单位:武汉大学计算机学院副院长)

声明:

凡文章来源标注为"CPS中安网"的文章版权均为本站所有,如需转载请务必注明出处为"CPS中安网",违反者本网将追究相关法律责任。非本网作品均来自互联网,转载目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。

相关阅读

征稿:

为了更好的发挥CPS中安网资讯平台价值,促进诸位自身发展以及业务拓展,更好地为企业及个人提供服务,中安网诚征各类稿件,欢迎有实力安防企业、机构、研究员、行业分析师。投稿邮箱: tougao@cps.com.cn(查看征稿详细)